[국제] 수학올림피아드 金, 알고 보니 구글 AI챗봇…"서술형 답안 놀라워"

-

3회 연결

본문

구글 딥마인드의 최고경영자 데미스 허사비스. EPA=연합뉴스

구글 딥마인드는 지난달 호주의 선샤인코스트에서 열린 올해 국제수학올림피아드(IMO)에서 인공지능 모델 ‘제미나이 딥 싱크’(Gemini Deep Think)가 인간 참가자들과 경쟁해 금메달에 해당하는 점수를 받았다고 21일(현지시간) 밝혔다.

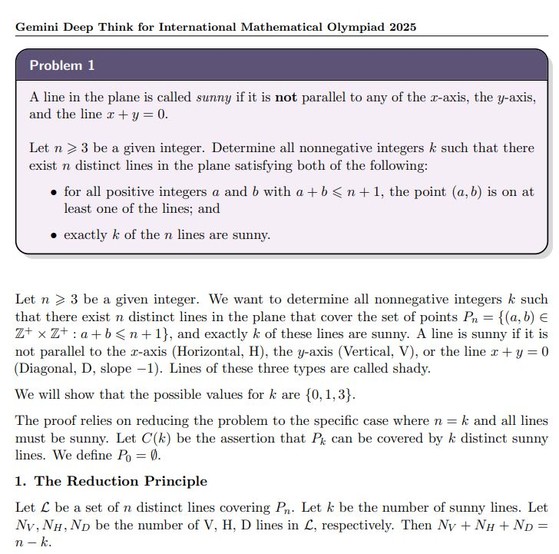

지난달 호주의 선샤인코스트에서 열린 올해 국제수학올림피아드(IMO)에서 구글 딥마인드의 '제미나이 딥 싱크'(Gemini Deep Think)가 인간 참가자들과 경쟁하는 가운데 제출한 답안지의 일부. 제미나이 딥 싱크는 이번 IMO에서 금메달 커트라인(35점)에 해당하는 점수(35점)를 얻었다. 사진 구글 딥마인드 제공

구글에 따르면 제미나이 딥 싱크는 이번 IMO에서 6문제 중 5문제를 풀어 42점 만점에 35점을 획득했다. IMO의 금·은·동메달 커트라인은 각 35점, 28점, 19점이었다. 구글은 “제미나이 딥 싱크는 인간 참가자들과 마찬가지로 인간 언어(영어)로 문제지를 받아 인간 참가자들과 동일한 제한 시간 내에 인간 언어로 서술형 답안을 제출했다”고 설명했다.

IMO 위원장인 그레고르 돌리나르 류블라냐대 교수는 “여러 가지 면에서 놀라웠다”며 “IMO 채점자들은 제미나이 딥 싱크의 답안들이 명확하고 정밀하며, 답안 대부분이 전개를 따라가기 쉬웠다고 했다”고 밝혔다.

구글 딥마인드는 지난해 IMO에도 자체 개발 AI ‘알파지오메트리 2’와 ‘알파프루프’를 앞세워 도전장을 내밀었다. 당시엔 두 모델이 은메달에 해당하는 28점을 받았다. 다만 이 때는 인간 전문가들이 인간 언어로 출제된 문제를 AI가 풀 수 있도록 컴퓨터 프로그래밍 언어로 번역해 줘야 했다.

뉴욕타임스(NYT)는 “지난 2년 동안 구글과 오픈AI 등은 복잡한 수학 문제 해결에 적합한 AI 시스템을 개발해 왔다”며 “구글은 수학, 과학, 컴퓨터 프로그래밍과 관련된 작업을 추론하도록 설계된 제미나이 딥 싱크를 통해 기존 챗봇보다 진화된 성능을 입증했다”고 짚었다.

올해 IMO에 쓰인 제미나이 딥싱크의 고급 버전은 아직 일반이 사용할 수 있도록 공개되지는 않았다. 수학자 등을 통해 테스트해본 후 월 구독료가 249.99 달러(약 34만6000원)인 ‘구글 AI 울트라’로 시중에 출시될 예정이다.

구글 딥마인드의 경쟁사인 오픈AI의 앨릭스 웨이 박사 역시 지난 19일 X(옛 트위터)에서 자사 AI 모델에 인간 참가자들과 똑같은 조건으로 올해 IMO 문제를 풀어보도록 한 결과 금메달 수준의 점수가 나왔다고 밝혔다. 다만 이는 오픈AI 자체적으로 실시한 내부 평가다.

댓글목록 0